Salut, je vous propose aujourd’hui un article où je vais présenter et installer Open WebUI d’Ollama, une interface graphique pour interagir avec des modèles d’IA.

Open WebUI, c’est quoi ?

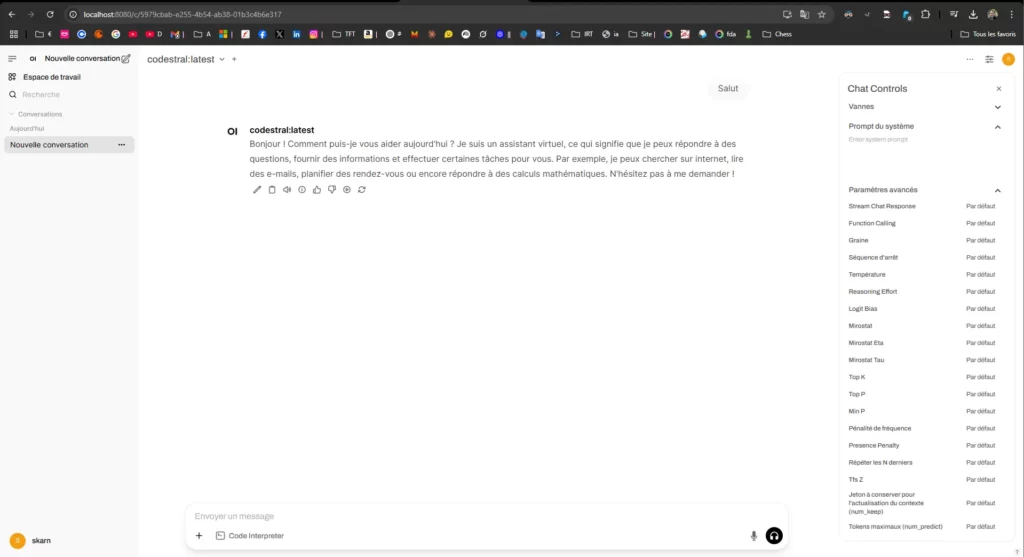

Anciennement nommé Ollama WebUI, c’est une interface graphique open-source qui transforme votre expérience avec Ollama. Fini les lignes de code tapées dans le noir d’un terminal : avec Open WebUI, vous obtenez une interface moderne, intuitive et personnalisable, un peu comme un ChatGPT local.

Avec vous pouvez :

- Discuter avec vos modèles via une fenêtre de chat.

- Gérer plusieurs modèles facilement.

- Accéder à votre IA depuis n’importe quel appareil sur votre réseau local.

C’est gratuit, léger, et ça rend l’utilisation d’Ollama beaucoup plus plaisante !

Prérequis

Avant de commencer, assurez-vous d’avoir :

- Ollama installé et fonctionnel : voir mon article dédié.

- Python 3.8+ installé (téléchargeable sur python.org si besoin), perso j’ai la derniere version de 06-04-2025 soit la 3.12.2.

- Git pour récupérer le code (optionnel, mais recommandé – disponible sur git-scm.com).

Installation pas à pas sans Docker

Docker est génial mais je ne l’ai pas encore installé sur ma machine et donc je vais vous montrer une méthode pour l’installer simplement avec juste quelques commandes et un peu de Python.

Étape 1 : Téléchargez Open WebUIgit clone https://github.com/open-webui/open-webui.git

D:\>git clone https://github.com/open-webui/open-webui.git Cloning into 'open-webui'... remote: Enumerating objects: 96053, done. remote: Counting objects: 100% (154/154), done. remote: Compressing objects: 100% (67/67), done. remote: Total 96053 (delta 112), reused 87 (delta 87), pack-reused 95899 (from 3) Receiving objects: 100% (96053/96053), 185.21 MiB | 39.25 MiB/s, done. Resolving deltas: 100% (63258/63258), done. Updating files: 100% (4596/4596), done.

Étape 2 : Accédez au dossiercd open-webui

Étape 3 : Installez les dépendances

Ici je pensais faire un pip install -r requirements.txt mais ils ont changé la maniere de faire, il faut passer par uv désormais :

# On l'installe via D:\open-webui>pip install uv Collecting uv Downloading uv-0.6.12-py3-none-win_amd64.whl.metadata (11 kB) Downloading uv-0.6.12-py3-none-win_amd64.whl (17.6 MB) ---------------------------------------- 17.6/17.6 MB 56.3 MB/s eta 0:00:00 Installing collected packages: uv Successfully installed uv-0.6.12 #Puis on créer l'environnement de Py D:\open-webui>uv venv Using CPython 3.12.9 Creating virtual environment at: .venv Activate with: .venv\Scripts\activate #Et enfin on le lance et on le met à jour D:\open-webui>.venv\Scripts\activate (open-webui) D:\open-webui>uv pip install . blabla...

Étape 4 : Lancez Ollama en arrière-planollama serve

(laissez cette commande tourner dans un terminal séparé), tu peux voir s’il tourne ici : http://127.0.0.1:11434

Étape 5 : Démarrez Open WebUIpython main.py

Si ça ne fonctionne pas, c’est car ils ont déplacé le fichier dans :

python main.py

Donc lance plutot :

python -m open_webui.main

Étape 6 : Ouvrez votre navigateur

Rendez-vous à http://localhost:8080

Et voilà !

Vous avez une interface graphique pour Ollama, sans CMD ! Tout fonctionne en local, et vous pouvez discuter avec votre modèle, ajuster les paramètres, et plus encore. Si ça ne marche pas, vérifiez que toutes les étapes ont été suivies et que les prérequis sont bien installés.

- Si une erreur mentionne Microsoft Visual C++, téléchargez les « Build Tools » sur visualstudio.microsoft.com et installez « Desktop development with C++ ».

- Si uvicorn n’est pas reconnu, installez-le avec

uv pip install uvicorn.